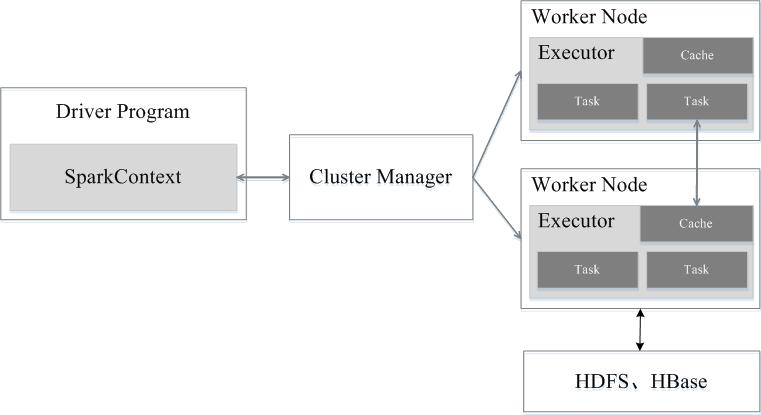

Spark运行架构包括集群资源管理器(Cluster Manager)、运行作业任务的工作节点(Worker Node)、每个应用的任务控制节点(Driver)和每个工作节点上负责具体任务的执行进程(Executor)。其中,集群资源管理器可以是Spark自带的资源管理器,也可以是YARN或Mesos等资源管理框架。

Scala的安装

因为Spark本身是以Scala开发的,所以必须先安装Scala. 2.4.x的spark ->选择2.12.x的scala

Spark运行架构包括集群资源管理器(Cluster Manager)、运行作业任务的工作节点(Worker Node)、每个应用的任务控制节点(Driver)和每个工作节点上负责具体任务的执行进程(Executor)。其中,集群资源管理器可以是Spark自带的资源管理器,也可以是YARN或Mesos等资源管理框架。

因为Spark本身是以Scala开发的,所以必须先安装Scala. 2.4.x的spark ->选择2.12.x的scala

使用Ubuntu19.10搭建一个编程工作站如何配置ubuntu在个人工作站与服务器领域都表现的非常稳定优秀,工程师使用ubuntu做为个人开发电脑完全没有问题,功能齐全性能...

使用Ubuntu19.10搭建一个编程工作站如何配置ubuntu在个人工作站与服务器领域都表现的非常稳定优秀,工程师使用ubuntu做为个人开发电脑完全没有问题,功能齐全性能... 在Ubuntu16.04使用命令行方式安MatlabLinux服务器命令行模式安装Matlab

在Ubuntu16.04使用命令行方式安MatlabLinux服务器命令行模式安装Matlab 如何使用Ubuntu16.04挂载硬盘操作前先要添加一块硬盘

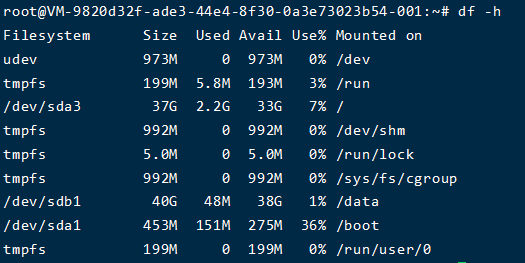

查看硬盘位置

sudo fdisk -l

根据磁盘大小,我挂的是40g的,所以很明显是 /dev...

如何使用Ubuntu16.04挂载硬盘操作前先要添加一块硬盘

查看硬盘位置

sudo fdisk -l

根据磁盘大小,我挂的是40g的,所以很明显是 /dev... 如何使用Ubuntu18安装Hivehive是基于hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表并提供类sql查询功能

如何使用Ubuntu18安装Hivehive是基于hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表并提供类sql查询功能 Linux出现Read-onlyFileSystem错误的解决方法造成这个问题的原因大多数是因为非正常关机后导致文件系统受损引起的,在系统重启之后,

受损分区就会被Linux自动挂载为只读...

Linux出现Read-onlyFileSystem错误的解决方法造成这个问题的原因大多数是因为非正常关机后导致文件系统受损引起的,在系统重启之后,

受损分区就会被Linux自动挂载为只读...博客内容遵循 署名-非商业性使用-相同方式共享 4.0 国际 (CC BY-NC-SA 4.0) 协议

本文永久链接是:http://norhub.com.cn/2020/07/21/%E5%A6%82%E4%BD%95%E4%BD%BF%E7%94%A8Ubuntu18%E5%AE%89%E8%A3%85Spark/

评论